守住自由意志 翻越數據背後風險

現代社會數據無所不在,可怕的是,你我似乎也離不開它。人類又該如何面對未來AI治理的世界?是被綁架還是能保有自由意志?或許是人類得嚴肅面對的課題。

顧問時薪以萬元計,台灣智慧資本執行長張智為最近卻將寶貴的時間拿來做一件看似不必要的瑣事:努力將10萬張存在Google相簿裡的照片下載到自己的電腦裡,之後再刪掉這些雲端照片。

緣由,或許是出自職業的本能。

免費網路空間,「只能繼續被綁架」

41歲的他常年經手上百億元專利交易,基於無形資產所有權的敏銳,令他對這項免費服務起了一份警覺心。

身為Google相簿的重度使用者,十年來,他存放了海量的家庭照片。這個軟體是如此聰明,每用手機拍一張照片就自動上傳,也總能準確辨識自己長得很像的三個孩子,好用到終於有一天讓他害怕失去。

「總是會擔心,如果它有一天不給我用怎麼辦?」張智為抿起嘴角道,左手順勢托起了下巴,像是托起莫名的憂慮。

於是,他想將寶貴的小孩成長照,在電腦硬碟裡也備份一套,一種被綁架的感覺也油然而生。

糟糕的是,儘管如此,他自知很難脫離AI的貼心服務,「我只能繼續被綁架。」

當科技巨擘提供免費服務,來換取你我的各項數據之後,人們可能不只是這些大企業的用戶,個人的數據還可能是它們的商品。

個人的數據資產彷彿變成大公司的了,這種被互聯網大咖公司等數據霸權宰制的感覺並不好受。「因為決定權是在那個霸主身上,」張智為認為,集權者判斷對的時候天下太平,「判斷錯大家都完蛋。」

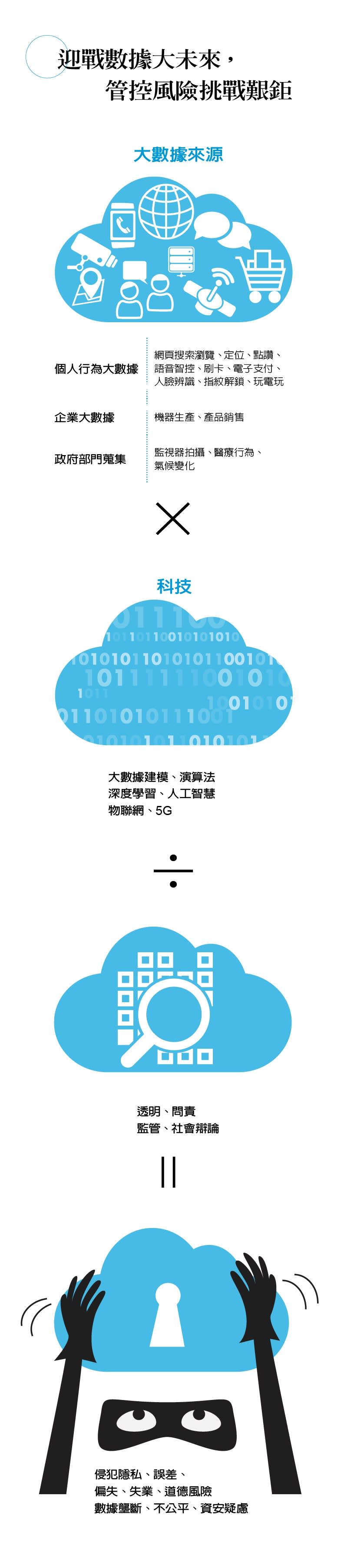

迎戰數據大未來,管控風險挑戰艱鉅。

人工智慧,可說是未來十年內最具破壞性創新的技術,也是最有價值的投資領域之一。但,隨之而來的風險也是愈發顯著。

當然,AI引發的問題不會只有數據霸權。資誠智能風險管理諮詢公司執行董事張晉瑞歸納,舉凡就業、不平等、隱私、網路安全、道德、社會責任等層面,AI都已經造成衝擊,就像被打開的潘朵拉盒子一樣,一發不可收拾。

高度演化的AI,對工作「入侵」有多深?去年科技巨頭亞馬遜發生的事,即為經典。

美國科技媒體《The Verge》,披露一份亞馬遜的內部文件,顯示有一套用來監控倉儲物流員工的AI系統,不但能追蹤每個人的工作進度,還能精確判斷員工有沒有偷懶,甚至可以根據即時數據,計算出「摸魚時間」,未達標準者,便自動生成解雇指令,作為開除工人的依據。

由於「AI決定我能不能保有工作」實在太驚悚,報導一出來,便引發社會輿論強烈抗議,抨擊亞馬遜違反美國憲法保障的公民權利。亞馬遜雖辯稱,(人類)主管有權限改變系統的解雇決定,但後續也因此制定相關的道德準則,讓自家軟體更加符合道德標準。

「我們用人類的道德標準來要求AI,」深入研究AI風險的張晉瑞,分析該案後得到結論是,AI只是技術,聽從人類指令,技術本身沒有對錯,「但用在某些地方,就會產生道德問題。」

的確,儘管AI是中性的技術,但根據人類設計的演算法做出的判斷,就是有可能產生歧視不公平。

核發信用卡涉歧視,蘋果挨告

2019年底,蘋果信用卡挨告案,即為鮮明案例。

首次跨足信用卡業務的高盛銀行,找上美國蘋果公司合作,打造這張號稱「地表最狂」的蘋果信用卡:整合了Apple Pay、現金回饋無上限、提供財務健康檢測等,功能強大無比,被譽為信仰之卡。

沒想到正式發行三個月後就吃上官司。一位科技公司老闆到紐約金管單位告狀,表示蘋果信用卡核定他的信用額度,是他太太的20倍;偏偏,在線下的信評機構根據信用歷史與過往履約能力,其實太太的信用分數(credit point)應該比先生還高。結果,以「性別歧視」的理由起訴蘋果信用卡,因為核卡標準貌似「男女有別」。

外部專家研判,問題應當出在蘋果信用卡的核卡系統,交給電腦演算法來設定的關係。

再細究下去,會更令人不寒而慄:每個人的網頁廣告,其實都是從過往搜索和瀏覽等大數據推導出來的。每一次的定位、點讚,也都在加強「有心人士」對生活的控制,透過監視、宣傳或行銷管道,成為潛伏於日常的「隱私大盜」。

有鑒於此,大數據分析公司賽仕(SAS)台灣總經理陳愷新就有個習慣,一定關掉手機上Google的GPS功能。他擔心,Google會知道他每天固定的移動路線,根據這些足跡數據,進而推算出他的上班地點、下班時間等。「數據是兩面刃,」陳愷新說,科技若剝離道德,其實有點可怕。

長期觀察科技趨勢的台灣大哥大總經理林之晨,便以著名的「電車難題」(Trolley problem),來比喻在自駕車會遇到的道德兩難。

台灣大哥大總經理林之晨提出電車難題,盼大眾思考AI的價值觀;張智傑攝。

假設在很窄的山路上,一輛自駕車載著總統,另一輛自駕巴士是20個小學生,兩車將對撞,且無法閃避,兩車在「智能溝通」後決定,得犧牲一輛車閃下山谷以避免對撞。難題是,到底要救誰?

接著,林之晨拋出的問題,一個比一個犀利:

「無論最終是救了總統還是小學生,誰來解釋AI為什麼做這樣的判斷?」

「如果沒有人幫AI解釋的話,是不是等於人類社會的決策與價值觀,留給沒有辦法解釋的機器來決策?」

「如此,是不是就違背了人類存在的價值?我們就沒有自由意志了?」

AI判斷價值觀,仍待人類辯論

在技術無罪的狀況下,對於AI的悲觀,其實是對人性弱點的悲觀。

癥結仍在於倫理尺度的拿捏。如果沒做好準備,人類一手主導的AI將會迎面撞上自己。更糟糕的是,如同電影情節,被自己仰仗的高科技反噬。

「社會應該來場大辯論,」林之晨表示,從2000年前希臘哲人的時代之後,人類社會再也沒有針對價值觀,進行大規模而廣泛的辯論。如果不在未來10到20年內,有更多關於AI價值觀的辯論與判斷:「可能會造成未來AI形成的狀態,並不是大部分人喜歡的。」

對此,人類還有計可施嗎?2020年2月19日,歐盟執委會發布的兩份新報告《人工智慧白皮書》及《歐盟資料策略》,嘗試了某些解方。

儘管這兩份文件都沒有法律效力,卻透出曙光:不僅點出AI應用及資料分享帶來的機會與利益,同時明定了AI的使用規範。譬如,必須要詳細記錄AI的訓練過程,以規避潛在的危機,同時列出歐盟即將採取的行動計畫。

基本上,兩份報告繼承了「史上最嚴的個資法」GDPR(歐盟通用資料保護規則)的精神,也難怪歐盟執委會副主席維斯塔格爾(Margrethe Vestager)會說:「中國有數據、美國有錢,而我們有意志。」所謂的意志,便是維護人權的精神。

張晉瑞鑽研報告後指出,歐盟AI白皮書其中有一個重要目的——建立信任生態圈(ecosystem of trust)。

諸如收集數據要廣泛,標註時避免偏見;演算法不可以隱含性別、宗教或種族歧視;訓練人工智慧的過程要記錄,決定機制要透明可解釋可追溯。

白皮書還定義了AI應用的風險值,高度風險的領域有個人健康照護、自駕車、物聯網,較低的則為金融科技、智慧工廠、智慧農業,後者相對前者比較不會直接危害到生命。

「因為只有這樣才會有信任,產業才發展得下去,」張晉瑞說,當歐盟提出了信任的作法,其他國家也會朝同樣的方向走。

擺對主次,監管整體原則

歐盟的舉措,是找出一套面對AI的總體原則,加以監管,以獲得一定程度的保障。

另一方面,如果人類永遠只把AI當成工具,在使用工具時,懷抱謙虛和更多人性,也不失為一種應對之道。

「AI對我來講,就是輔助式的智能,」行政院政務委員唐鳳說。面對AI的隱憂與風險,唐鳳提醒,擺對自己與AI的主次位置很重要,不要放棄自由意志的選擇。

唐鳳舉例,假設你有一個助理,自顧自地幫你決定行程,而且透露你的隱私,你肯定馬上炒了這個助理。「你是怎麼期待助理的,就怎麼期待輔助式的智能,」唐鳳如此總結。

如何發展AI?如何管理AI?能否相信AI?就在政府與企業熱中於數據科技中挖掘金山的此刻,面對「數據風險」這頭房間裡的大象,再也不能視而不見。

本文轉載自遠見雜誌

Yahoo奇摩新聞

Yahoo奇摩新聞