知人知面也知心?(下)面部辨識科技和危險的未來

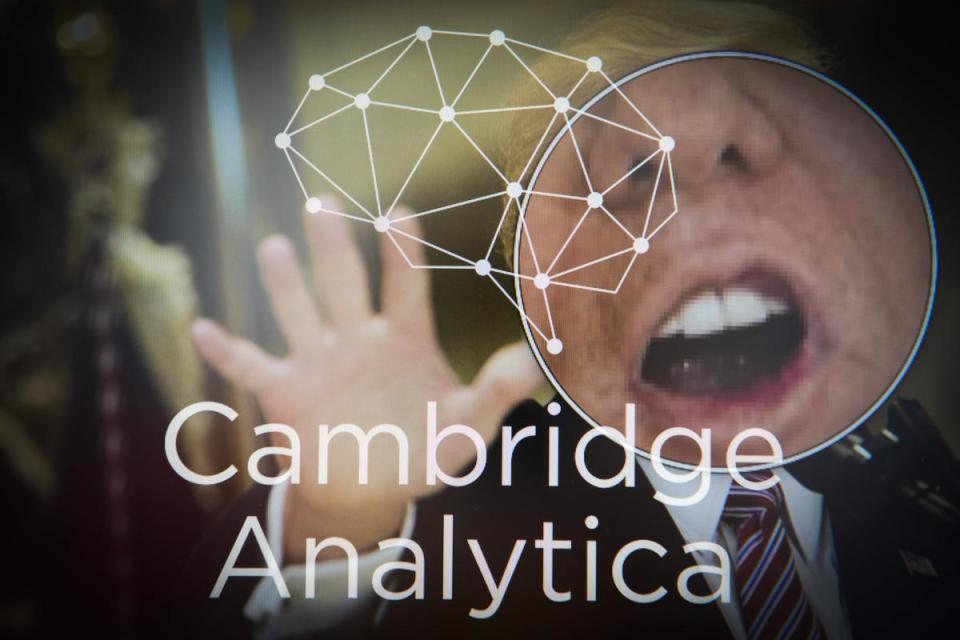

克辛斯基和史提維爾的這些研究受到了「劍橋分析」的母公司SCL集團的注意。這個在世界各地從事選戰的集團,有意吸收兩人進公司,應用他們的數據和預測模型,來進行目標行銷(target marketing)和大眾說服(mass persuasion)。

克辛斯基:做炸彈的不是我

SCL集團與他們的合作談判最後並未成功。SCL找了劍橋大學另一位心理系的學者柯根(Aleksandr Kogan)。柯根運用自己發展的人格測驗,並且付費給在臉書上接受測驗的使用者,收集到32萬名美國人的個人資料。利用程式上的漏洞,程式開發者又(在未事先告知的情況下)收集到了這些使用者的朋友的數據,總計收集到了8700萬人的資料。

今年稍早「劍橋分析」的醜聞曝光時,揭露事件的「吹哨者」威利(Christopher Wylie)詳細說明了「劍橋分析」這家公司如何複製了克辛斯基的研究工作,並形容這套方法已成「心理戰的利器」,是選戰中威力驚人的新武器。

不過,在瑞士雜誌《Das Magazin》的訪問中,克辛斯基表示:「製造炸彈的人不是我。我只不過是展示它的存在。」

劍橋分析公司因這起醜聞而關門,臉書公司在事件後也一度市值慘跌。克辛斯基認為政治上這種不當的「微型目標」(micro-targeting)行銷,加深了人們對心理測驗分析的不良觀感。但是他認為「整體而言它仍是很好的科技,對民主也是好事」。他說:「如果你的政治訊息能鎖定目標,契合人們的利害、夢想、和人格,那麼這些訊息就更有相關性,讓選民更投入其中,而選民越投入其中對民主體制就更好。」

克辛斯基對「劍橋分析」事件較大的批評,是它製造了一個「錯覺」,讓我們以為政府有辦法保護數據,和保障公民的隱私。在他看來其實毫無希望:「我們應該把重點放在組織我們的社會,讓社會在後隱私時代仍是可以居住、且適宜人們居住。」

克辛斯基說他從沒打算要去證明AI可以預測人們的性傾向。他形容這完全是偶然。當他為其他研究計畫開始過濾臉書的用戶檔案資料時,突然注意到這些人的面部特徵有一定的模式。他說這讓他靈光一閃:「內向的人和外向的人有完全不一樣的臉孔。我想到:『哇,從這裡應該可以挖出些東西。』」

天生的犯罪者?

所謂的「面相學」(physiognomy)歷史久遠,不過西方在十九世紀達到極盛。義大利的人類學家龍布羅梭(Cesare Lombroso)在他出版的著名生物分類學著作裡,宣稱「幾乎所有罪犯」都是「招風耳、濃髮、薄鬚、血管突張、長下巴、寬顴骨」。這種分析根植於種族主義的觀念,認為罪犯面貌和「原始人和猿類相近」。龍布羅梭搭配了許多刑事犯罪的紀錄作證,小偷通常「有眼神飄忽的小眼睛」,強暴犯「雙唇與眼皮浮腫」,而謀殺犯則有「巨大的鷹鉤鼻」。

龍布羅梭的遺體如今仍陳列於杜林的博物館,在他旁邊則是他花了數十年研究,數以百計罪犯們的頭骨。他當時用的是測徑器和顱型描繪器,而克辛斯基則是從網路抓圖找尋出模式。

克辛斯基認為龍布羅梭的面相學是「偽裝成科學的迷信與種族論的混合物」,但是另一方面,他的研究方法與龍布羅梭卻有不少相似之處。他相信有越來越多的證據可以支持面容與心理學之間相關性確實存在。他甚至認為,即使人眼無法看出這種關聯,如今也可以透過機器學習而察覺出來。

比人還準的「AI同志雷達」

克辛斯基在去年與研究生王義倫(Yilun Wang,音譯)發表的論文中,宣稱透過機器學習系統,他們可以辨識出照片中人是否為同性戀。他們從約會網站擷取35,326張照片,使用現有的面部辨識軟體進行實驗。

演算法必須從兩張照片中——一張為同性戀,另一張為異性戀——辨識何者是同性戀。結果它分辨男同志的準確度達81%,女同志則是74%。相對之下,人類做的判斷顯然不如機器。人們分辨男女同志的準確度各只有61%和54%。

對這個發現令我大感驚訝,演算法可以這麼容易就分辨出同性戀和異性戀。

克辛斯基,史丹佛教授

還有許多其他人也同樣驚訝。這個被媒體戲稱為「AI同志雷達」的研究引發了美國最知名的兩個LGBTQ團體的抗議,要求史丹佛大學校方與這個「危險而且有疏漏」的研究劃清界線。克辛斯基的電子信箱被來自四面八方的郵件灌爆。甚至有人說對自己的性傾向有所困惑,提供了照片希望演算法幫他們辨認(被克辛斯基婉拒了)。也有人批評他運用的科技,可能被伊朗或沙烏地阿拉伯當局用來迫害同志,在這些國家,同性戀最高可被判處死刑。

克辛斯基說批評者搞錯了重點。他說:「提醒人們某個工具的危險性時,存在著一個先天的矛盾。我自己也對研究的結果感到為難,我差點就決定把它收進抽屜裡不要發表了,因為不發表這個論文我照樣過得好好的。」不過,一個同僚的話改變了他,他說,這個同僚問他:「如果有一天,某個公司或某個政府引用類似的科技來傷害人們,我是否還能看著鏡子正視自己?」他認為隱匿實驗結果「是道德上的錯誤」。

批評克辛斯基的陣營中包括了普林斯頓的托多洛夫教授(Alexander Todorov),他進行過一些被廣泛引用的,關於臉與心理學的研究。他認為克辛斯基的研究有嚴重的疏漏:他比較照片所用的演算法可能和臉部特徵其實沒太多關係。

托多洛夫和兩位谷歌的人工智慧研究員曾寫文章批評克辛斯基的演算法對應的可能是人們照片中的化妝、鬍子、和眼鏡、或甚至是他們拍照的角度。托多洛夫認為,在約會網站上許多自拍的照片,事實上透露了很多非關臉部特徵的線索。

克辛斯基承認他的機器學習的確偵查了一些無關的訊息,不過他認為他的研究發現與性傾向的先天荷爾蒙理論相符。這套理論認為,胚胎在子宮內暴露在雄性激素的程度會決定日後的性傾向。克辛斯基認為,這個雄性激素同樣也決定了「性別非典型的臉部形態學」(gender atypical facial morphology)。他在論文中說:「同性戀男性根據預測下巴較小、眉毛較細、鼻子較長、前額較寬. . .。女同性戀則反之。」

人只是生物計算機?

克辛斯基的研究在此處似乎落入了生物學的決定論。他似乎淡化甚至忽略了我們人格形成的社會與環境因素。有時候,他和龍布羅梭的說法幾乎如出一轍。龍布羅梭質疑犯罪者有所謂的「自由意志」,他認為犯人應給予「憐憫」而非「懲罰」,因為就和其他動物一樣,他們「先天被設定會做壞事」。

克辛斯基說他「不相信罪惡」,因為他也不相信「自由意志」。他也不介意把人比喻成「生物的電算機」(biological computer)。他認為一個人的思想和行為「完全是生物性的,因為它們都是源自你腦中的生物電算機」。他說:「如果你基本上接受我們只不過是個計算機,那麼計算機本身並沒有罪。計算機有可能故障。但是那不是它的錯。」

托多洛夫認為,克辛斯基的研究有嚴重的倫理問題,等於幫有意使用這種技術的政權背書。他在兩年前的論文中提到,中國的人工智慧研究者已宣稱他們的面部辨識演算法可以預測某個人是否為罪犯,準確率達到九成。這個研究使用的是中國官方提供數百個男性罪犯的檔案照片,論文未經過同儕評審,研究方法和推論也遭托多洛夫嚴厲的批判。托多洛夫認為「人工智慧和機器學習的發展,已助長科學種族主義進入了新時代」。

克辛斯基對此有不同的看法。他認為即使中國的研究在結論上站不住腳,並不表示設計實驗的主張就是錯的。

他說:「我並不認為我們無法從某人的臉孔預測他的犯罪傾向。比如說,我們都知道睪固酮的濃度與犯罪傾向有關聯,也和臉部特徵有關聯——而且這只是其中一個關聯。可能有數以萬計甚至數以百萬計其他我們所不知道的關聯,可以被電腦很容易地偵查出來。」

那麼,他自己是否會做類似的研究?克辛斯基顯然有些猶豫,他認為「犯罪」是個太過於模糊的標籤。照他的說法,比較合理的做法是「研究我們是否偵查出一些——例如攻擊性的行為——對個人或社會有危害的特徵」。他也強調:「我認為必須有人來做. . .。如果説這是有高度風險的科技,一些政府和企業很顯然已經開始在使用了。」

參考資料:Guardian

更多鏡週刊報導

拿手機對著老闆的臉解讀情緒?臉孔辨識應用未來的詭異場景

川普當選 臉書遭殃 都是這個28歲粉紅小子的傑作

【AI大眾化(上)】谷歌推出雲端服務 幫助企業打造機器學習系統

Yahoo奇摩新聞

Yahoo奇摩新聞