Google Lens 的複合搜尋功能將擴展至其他語言

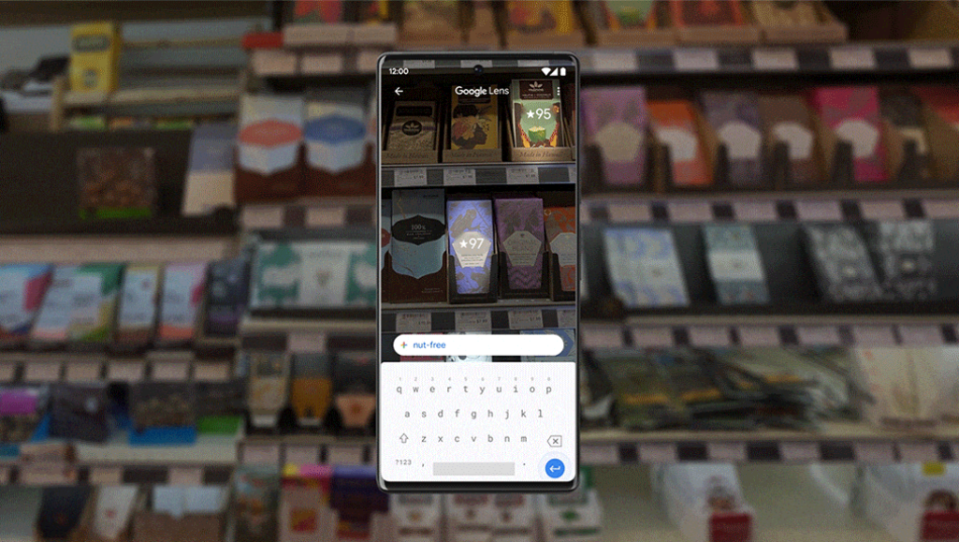

今年年初的 Google I/O 2022 上,他們發表了可以結合圖像和文字的複合式搜尋功能 multisearch,並先在美國進行測試。今天這搜尋巨擘宣佈會在未來幾個月陸續加入 70 多種不同語言的對應,讓更多不同地區的使用者都可以享用這功能。另一邊廂,同場發表的 Near Me 功能,能加入自己身處地區為搜尋條件的另一種複合用法,也會在今年年底在美國開始試行。

With multisearch, you can take a pic *and* ask a question to get the look you want or fix something. 🤯 We're bringing this new way to search to 70+ languages. And soon, you'll be able to add "near me" to your image to find what you're looking for nearby. #SearchOnpic.twitter.com/RHxRQm42EU

— Google (@Google) September 28, 2022

Multisearch 透過引進 Multitask Unified Model(MUM)到 Google Lens 裡,讓使用者可以在拍攝照片、匯入圖片之後,再加入文字來調整更個人化的搜尋結果;配合地理位置的 Near Me 則是可以讓使用者更容易發現到周邊的本地商店。

除此之外,Google Lens 的實時文字翻譯功能也變得更美觀,他們引進了 Pixel 6 的魔法橡皮擦功能,把原有的外文抹得更乾淨,並貼上相近風格的翻譯內文,讓結果有如原生圖片似的。

What you love about Translating with Lens is now even better. 💡

With major advancements in AI, translated text appears seamlessly integrated, as if it was part of the original picture. Turning text… into context! #SearchOnpic.twitter.com/N8YySv87z1— Google (@Google) September 28, 2022

Yahoo奇摩新聞

Yahoo奇摩新聞