【圖解】VMware攜輝達、英特爾助攻企業級AI,拚「效率」打贏GPU資源戰

隨著今年生成式AI爆發,企業紛紛想投入自家的機密資料訓練「專屬大腦」,但GPU已經是高價稀缺資源,即便是滿手捧錢的大型企業,也難以支應龐大的GPU需求。該怎麼辦?

購買一台伺服器對企業來說是必要任務也是負擔,成本高、消耗電力、佔用空間而且需要維護。如果可以用一台功能幾乎完全相同的「虛擬設備」,把硬體的功能轉化為軟體,就可以像在管理應用程式一樣,輕鬆維運自家的伺服器。

這就是軟體大廠VMware一直以來耕耘的領域,早從2008年就確立了「GPU虛擬化」的技術走向,目前全球已經有多達30萬家公司的系統,都在VMware平台上運作。

VMware抓緊商機,宣告攜手AI世代兩大GPU巨頭輝達(NVIDIA)和英特爾(Intel),攻進企業私有AI領域,能夠讓企業把AI建立在自己的資料中心或伺服器中,不需要經手其他大型雲端公司,或者擔心被餵給通用的AI模型訓練。

VMware技術長基特.寇伯(Kit Colbert)在接受《數位時代》採訪時指出,企業在導入生成式AI面臨缺乏GPU的問題,VMware的技術能夠協助企業做到兩件事:向上擴展(Scale-up),和向外擴展(Scale-out)。

向上擴展:GPU使用效率提升、共享資源效率

所謂的向上擴展,指的就是讓企業能利用到更大量的GPU資源,而在資源有限的情況下,需要提升的是「使用效率」。

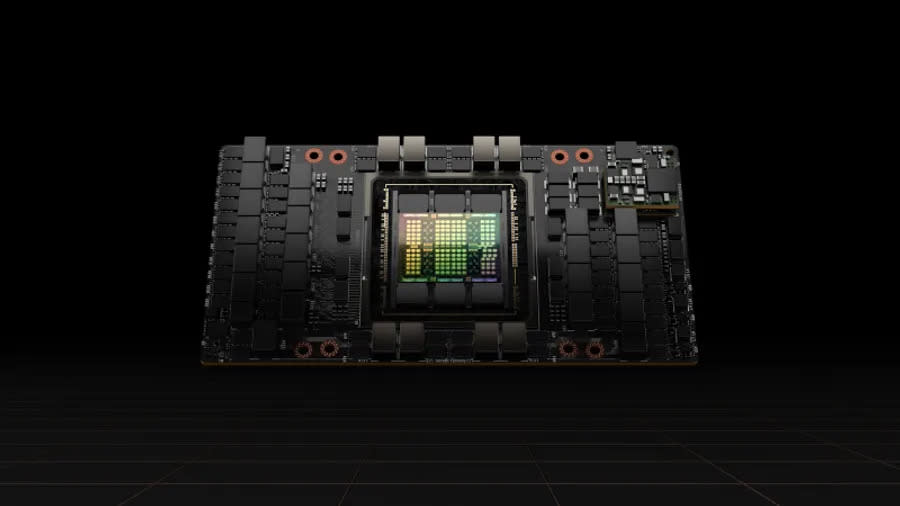

VMware的技術能夠把目前的高階GPU伺服器也化為虛擬機,也就是把實體伺服器轉化成虛擬版本的「雙胞胎」,在公司的軟體系統上運行。

實體伺服器無法被切割,在運算工作時需要一整包算力all-in使用,但「虛擬雙胞胎」可以被切分成多個,靈活供應給不同需求的工作負載,例如消耗大量運算的工作就分配到4個虛擬GPU,少量運算的工作就只要用到1個虛擬GPU的資源即可。

這項技術實現了企業需要的「效率」,不必買下所有需要的GPU量全力運轉,用不到的資源甚至可以和其他用戶共享,大幅提升利用率。

除了共享外,VMware也在今年推出和NVIDIA合作開發AI平台,藉由NVIDIA的技術,讓平台中運行的虛擬GPU容量一口氣從8個翻倍到16個,「我們把硬體和軟體整合起來變成一整套的解決方案。」估計可讓數十萬家企業運行生成式AI,新平台預計2024年初上市,確保自家客戶可以掌握AI時代最稀缺的GPU資源。

延伸閱讀:VMware攜手NVIDIA發展私有雲,會「惹到」公有雲巨頭嗎?一文看懂衝擊

向外擴展:部署在更多環境,應用更多元

負責Private AI產品的VMware Private AI Lab副總裁克里斯.沃夫(Chris Wolf)指出,在生成式AI崛起後,真的有更多客戶對「私有雲」重新產生需求,尤其是金融業、醫療業等手握大量機密資料的客戶,希望訓練出能了解產業知識和公司現況的AI模型,但又無法把所有資料丟上雲,若是和業界對手一起共享運算資源,更是如坐針氈,「通常當我們跟客戶說可以幫他們在私有環境運行AI時,他們才對導入AI產生高度興趣。」

這讓VMware重新定義了私有雲的地位,執行長蘭加拉詹.拉古拉姆(Rangarajan Raghu Raghuram)直言,Private AI將是未來的一大發展重點,除了和NVIDIA攜手外,11月還宣布和Intel也推出獨立平台。

Private AI能夠讓企業在自己公司的資料中心或伺服器中建立、運行AI模型,不用擔心系統跑不動或放不下巨大模型的問題,同時在平台上還能使用VMware和NVIDIA提供的預訓練模型和開發工具,讓導入AI的門檻更低,建立智慧聊天機器人、資料助理、公司內部系統搜尋和摘要等功能都可以快速上手。

談起VMware在這場生成式AI大戰中的策略,拉古拉姆只用一句話概括:「這是我們一直以來都在做的事。」在虛擬化技術的領導者眼中,也許這場「GPU資源爭奪戰」早在多年前就已經開始。

延伸閱讀:GPT-4為何這麼強?輝達GPU如何助攻?OpenAI首席科學家、黃仁勳解密

責任編輯:林美欣

更多報導

Google在Epic Games訴訟慘敗!為何蘋果完勝,開放錯了嗎?付費是賄賂、還是給折扣?

AI自動生成Sitemap、Wireframe!Relume多好用?「NoCode架網站」必收

Yahoo奇摩新聞

Yahoo奇摩新聞