【專欄】元宇宙的2大關鍵基礎設施:貼近真實的虛擬化身與輕鬆創造的3D模型

2021年起,關於元宇宙(metaverse)的討論變得熱門起來。雖然至今人們對此一詞彙仍沒有共識,但這並不影響每個人釋放自己對未來的想像。不過,我比較不擅長談想像,因此這篇將從目前已經可見的科技進展中來一窺未來的可能性。

關鍵一:貼近真實的「人造」虛擬化身

我認為元宇宙中最關鍵的元素之一是 虛擬化身(avatar) ,也就是「我」是誰。Facebook 母公司 Meta 於 2019 年首次發表虛擬化身系統Codec Avatars 1.0,整件系統運作分成兩部分:先在一個特殊攝影棚內用171台照相機取樣一個人的臉部畫面資訊,之後在VR裝置中即時算繪(render)該模型。

「為什麼要這麼麻煩呢?都要看真人了,直接視訊對話不就得了?」或許很多人會抱著這個疑問。然而,視訊是 2D 的,無法傳達3D的質感與真實度。此外,近乎真實的「人造」(synthetic)影像有更多可能性,例如更換性別、改變造型、使禿頭擁有飄逸長髮等。

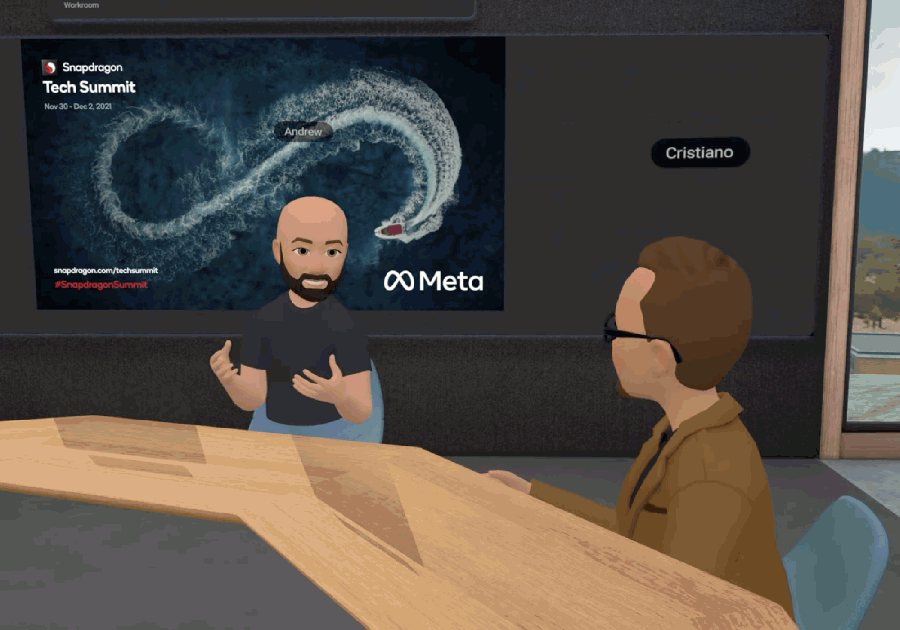

Codec Avatars 主打「真實」,但有在 Oculus 2 上玩過 Horizon Workrooms 的人應該都知道, Meta 目前的內建虛擬化身很「卡通」,原因有二:第一,系統並沒有使用者本人的模型資料;第二,為了在 Oculus 2 上即時算繪多個化身,顧及效能的情況下,只好算繪較單調的模型。

不過,Meta最近發表了 Codec Avatars 2.0,相較1.0有不少強化處。真人模型雖然還是得進特殊攝影棚取樣,並且送進神經網絡當中學習;但大幅進化的演算法可用更少鏡頭數來即時算繪模型,且算繪性能更好,最高可同時算繪5個模型。

我認為卡通化身與真人化身並不衝突,且可以並存。在多人場合中,卡通化身可兼顧效能與溝通需求;在一對一或少數人互動的場合,真人化身可讓遠距溝通的臨場感更強。不過,Codec Avatars 目前都還只是研究階段的產物,距離商用化還有一段不小的距離。

關鍵二:3D模型的創造解放

元宇宙中除了「我」是誰以外, 另一個重要的元素是 3D 模型 。人們現在能用各種工具輕鬆創作出有設計感的圖像與影音,但要輕鬆創造出3D模型還有一大段距離。

用手機相機掃物件,輸出3D模型這件事並不新,至少有8年的發展歷史。不過,當3D引擎領頭羊Epic Games自己跳下來做時,還是能引起我的注意。Epic Games宣布與Capturing Reality跟Quixel合作推出RealityScan應用,展示影片中呈現的效果超級嚇人,以後人人都是建模師。

RealityScan的運作方式跟其他同類型的應用不太一樣。由於主打「精緻模型」,RealityScan操作起來較麻煩。首先,你不是拿著手機「掃」物件,而是不斷「拍」照片,最少需要拍20張,拍愈多建出來的模就愈細緻。其次,RealityScan不是在終端算圖,而是把照片丟回雲端。好處是可以算出更精細的模型,而且也方便資產管理。

解放人們的3D模型創造能力,是許多大廠著眼的未來趨勢。文字、聲音、圖像的製作工具愈來愈多、愈來愈強大,還愈來愈易上手,剩下一個高度專業、或說「高度手工業」的創作領域就是3D模型了。除了技術門檻比較高,「需求」比較沒這麼多也是另個主因。人人都需要用文字、聲音、影像來表達,但不一定需要用到3D模型。不過,這個狀況即將被一個關鍵字打破,沒錯,又是「元宇宙」。

如果「所謂的」元宇宙是一個開放、共創(UGC)、可交互(interoperable)的虛擬空間,那麼解放人們 3D 模型的創造力可謂至關重要,因為它不僅是創意的基點,也是交易標的。

最後,上述內容都牽涉到不同程度的「手工」,未來有沒有可能交給 AI自動生成內容?最近電腦生成內容領域最大條的消息之一,莫過於OpenAI發表了新版的文字轉圖像(text to image)模型:DALL-E 2(發音同藝術家達利)。DALL-E 2是一個基於CLIP的AI模型,使用者只要給出文字描述,該系統就能自動生成2D圖像。

DALL-E 2與另個有意思的領域有關:2D圖像轉3D。Nvidia在今年3月的發表會上發表了改良版的 Instant NeRF,一個2D照片轉3D技術。

Instant NeRF 是加州大學柏克萊分校、Google研究院與加州大學聖地牙哥分校研究人員在2020年提出的運算模式,可用大量2D平面照片合成擬真的 3D場景。Nvidia表示,透過針對自家顯示晶片所特化開發的神經網路學習方式,將大幅縮減 Instant NeRF 的運算時間,可在幾秒鐘內將2D 照片轉換成擬真的3D場景,還能詮釋擬真光線與景深表現,讓視覺表現不會顯得突兀。

透過文字產生擬真3D物件、3D場景,會是一個比產生影片還要快實現的技術道路嗎?我認為這個發展將比透過文字產生影片更加有趣。 凡是能透過數位與網路的方式創造豐盛(abundance)的領域,必將創造出新的財富泉源,因為網路、或者說科技進步的價值,從來不是創造稀缺(scarcity),而是打破稀缺。

責任編輯:傅珮晴、蘇柔瑋

更多報導

台灣第一個兒童NFT平台,「元夢家kidznft」誕生,兼具投資與教育超值賦能

Meta上市10周年,技術故障還與摩根士丹利曾被告,2012年掛牌時還有小插曲

Yahoo奇摩新聞

Yahoo奇摩新聞