讓AI「長出手」,自己學會Google、找計算機!Meta新訓練方式Toolformer厲害在哪?

從去年開始,許多人工智慧工具開放公眾使用,從AI圖像生成工具Midjourney、Stable Diffusion揭起大眾的興趣,再到去年年底人工智慧聊天機器人ChatGPT成為公眾話題。儘管讓AI生成圖像和文字相當有趣,但這些工具要進入我們的日常,還有很長的一段路──大多數AI模型都有其局限性,例如沒有最新的資料、會對事實產生「訊息幻覺」、缺乏進行精確計算數學等等。

在ChatGPT還在嘗試克服這些缺點、挑戰Google搜尋引擎地位的同時,Meta冷不防從一旁殺出,用一篇新論文實踐這些問題的解套:讓AI自己使用外部工具。換句話說,如果AI沒有最新資訊,那就讓它自己搜尋最新的資料;如果不會算術,就去找計算機,諸如此類。

生成字句的同時呼叫API,將問題與運算「外包」

這個方法不是Meta獨創,但是被稱為「Toolformer」的這個方法也克服了先前讓AI使用外部工具的障礙;原先的方式仰賴人工註釋,或需要限制在特定的任務內容,導致語言模型與外部工具的結合難以推廣。但Toolformer在產生文字的過程中,遇到特定字詞或需求,就會直接呼叫工具的「API」,叫出搜尋引擎或是計算機。

例如,讓ChatGPT相形見絀的算數:

或是確切日期,呼叫月曆來查詢:

甚至直接搜尋:

Toolformer經過優化,可以自主決定要使用哪些API,以及使用哪些參數來運算或是查詢。而這個的學習過程被稱為「自我監督」:研究人員只需要讓語言模型學習「少量」人工編寫的API呼叫範例,而這些範例已經被手動標註會使用到API的部分。然後再讓語言模型去生成更多包含這些範例的資料庫。

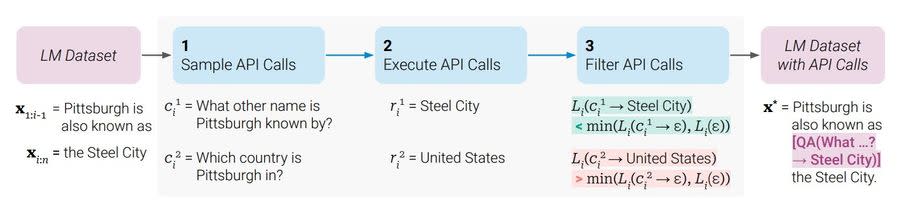

而訓練的過程分成三個步驟:第一是取樣,就是看輸入到語言模型的文字當中,哪些地方可能會需要那哪些工具,就直接把要呼叫API的指令插入句子當中。再來,就是執行這項API指令,並把產生的答案插入對應的部分。

第三步是過濾,如果第二步所生成的文字對整句話的意義不大的話,就會直接剔除,僅保留整句話原本所需要的資訊。

與其他大型語言模型比較起來,Toolformer又有哪些厲害之處?

在Meta的論文當中,比較了Toolformer與多個其他大語言模型,包括GPT-J,OPT(66B)以及GPT-3(175B)在數學、問答以及機器翻譯等方面的能力;研究結果顯示了在學習使用工具後,GPT-J的零樣本學習能力明顯增加,甚至優於GPT-3模型。在數學、QA與LAMA基準測試上的平均表現也有所增強。

研究人員也表示,使用API除了能得到更精準的輸出結果,語言模型自身使用外部工具的能力,也可以解決例如數學運算與事實查核等大型語言模型常有的問題。

不過同時,研究人員也指出,這個系統還是有其局限性。例如,API工具無法連續使用,或是使用一個輸出作為下一句的輸入,因為每個工具的指令是獨立生成的,導致應用範圍有所限制。

延伸閱讀:明明也擁抱AI,祖克柏在AI大戰中版面超少?Meta 科學家喊冤:我們不夠「好命」

語言模型掌握工具,已是未來語言模型發展趨勢

科技巨頭的人工智慧之戰,加入戰局的Meta顯然也不輸微軟與Google;雖然現在聲浪尚無法比上ChatGPT引發的一片譁然,但Meta讓語言模型對工具的使用自主性與熟練度更了上一層樓。

儘管Toolformer所展現出的「自學」能力可能還是個雛形,但顯然語言模型發展的下一步,就是要訓練它們知道在什麼時間、要用什麼工具,且一切的輸入、輸出都可以轉化成自然語言。

這勢必會全然改變人們操作電腦與網頁的方式,而現在也不只Meta走向這個潮流;微軟的Bing搜尋引擎將接入ChatGPT,而Google推出的人工智慧Bard即將嵌入到Google搜尋當中。

資料來源:the decoder、Towards AI、新浪科技

責任編輯:錢玉紘

更多報導

AI大戰中,祖克柏版面超少?Meta AI 科學家:我們也有技術,只是沒那麼「好命」

ChatGPT拔得頭籌的秘密:挖角前Google AI員工!搜尋巨頭為何留不住人?

Yahoo奇摩新聞

Yahoo奇摩新聞