AI語音模型可能"以假亂真"? 恐成詐團犯罪工具

財經中心/楊思敏、郭文海 台北報導

全球已進入AI革命時代,應用範圍也越來越廣,日前OpenAI開新的AI語音模型,只要利用15秒音檔就能生成,不只能作為影片旁白使用、影片可以翻譯成不同語言,還能幫病人重建聲音。但這也引發疑慮,擔心會被詐騙集團濫用,以假亂真,成為犯罪工具。

民視記者楊思敏:「接到電話,聽起來很像是朋友的聲音,但要注意了,可能不是真的。因為隨著AI技術越來越發達,不少平台推出AI語音生成功能,未來是否可能成為詐騙集團的工具,引發疑慮。」

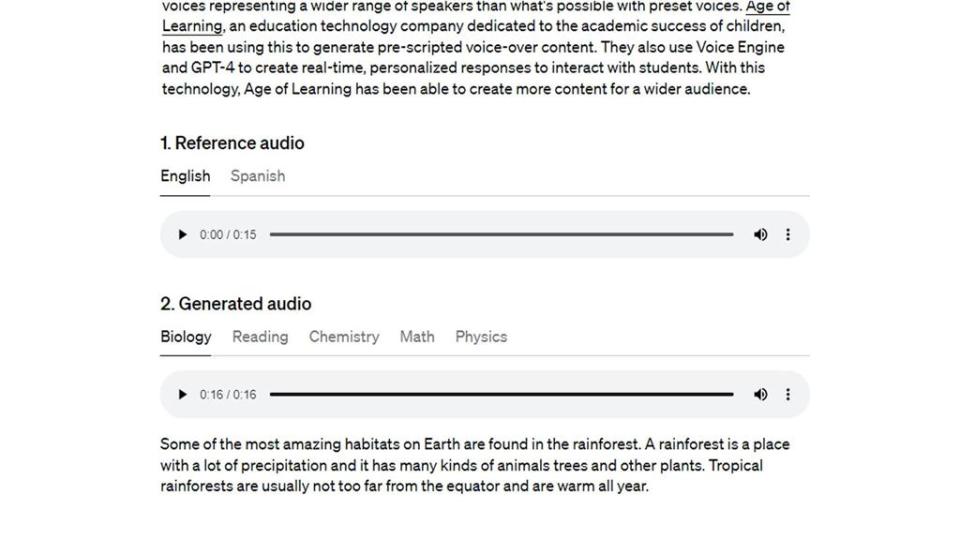

Open AI 30日宣布推出AI語音模型「Voice Engine」,只要輸入想講的內容,利用一個人15秒鐘的音檔,就能生成本尊的聲音,甚至還帶有情緒。

教材業者利用配音者的一段聲音,就能作為不同教學影片的旁白使用,更厲害的是,還能保留情緒和口音

新的AI語音模型只要利用15秒音檔,就能生成本尊的聲音。(圖/翻攝自Open AI官網)

原本美國人講英文,利用AI轉成中文時,還保留英文口音,仿真程度相當高。但詐騙猖獗的年代,不免讓人擔心,越真就越可能被利用,專家說目前只能靠電腦,用耳朵聽很難辨識。

台科大資通安全研究與教學中心主任查士朝表示,可能的手法會是透過一段語音檔,去抓到聲紋特徵,再生成其他內容,但目前介面上還不能能夠做到即時回應,需要生成的時間,但這只限於這一段時間,可能未來就能做到。

民眾表示,相當擔心AI會被詐騙集團濫用。(圖/民視新聞)

民眾表示,現在詐騙猖獗,不用那麼真的情況下,已經有很多長輩容易被騙,「以假亂真,那我覺得被騙,應該算是機率一定會很大幅提高。」也有人提到,AI進步技術很快,現在都已經可以寫歌了,當被用來詐騙時,也沒辦法分清楚到底是真的假的。」

Open AI從去年開始,與一些企業和機構測試,目前還沒公開使用。雖然一再強調,合成內容都會標示非真人、壓上浮水印,但未來應用越來越廣,能否確保AI不被詐騙集團濫用,還很難說。

原文出處:AI語音模型可能「以假亂真」? 民眾疑慮恐成詐團犯罪工具

更多民視新聞報導

杜奕瑾:AI分析總統大選期間 出現大量呼應中方論述「假訊息」

迎AI藝術浪潮 金曲獎作曲人創立平台保障創作者

女子誤信投資詐騙險匯16萬 桃警及時勸阻守住她荷包

看更多相關新聞

可假冒人聲的AI系統廣泛測試中 OpenAI要了解它有多危險

復興商工美展「冠軍作品AI畫的?」吹哨學生遭施壓 冠軍得主疑自爆了

取代人力難且貴 企業想引進生成式AI挑戰多

「NVDIA、台積電是賣鏟子的人!」陳鳳馨以淘金類比AI:2類公司有望成為大贏家

微軟擬與OpenAI聯手 開發1000億美元AI超級計算機

Yahoo奇摩新聞

Yahoo奇摩新聞