AI領域強敵環伺!亞馬遜左推自研晶片、右攜輝達合作,能殺出一條血路?

在美國德州奧斯汀市的一棟辦公大樓裡,可以看見一群亞馬遜(Amazon)員工來回穿梭在兩個房間之中,他們所擔負的是亞馬遜目前最重要的工作之一——自研晶片「Inferentia」和「Trainium」,分別用於訓練和加速大型語言模型的開發。

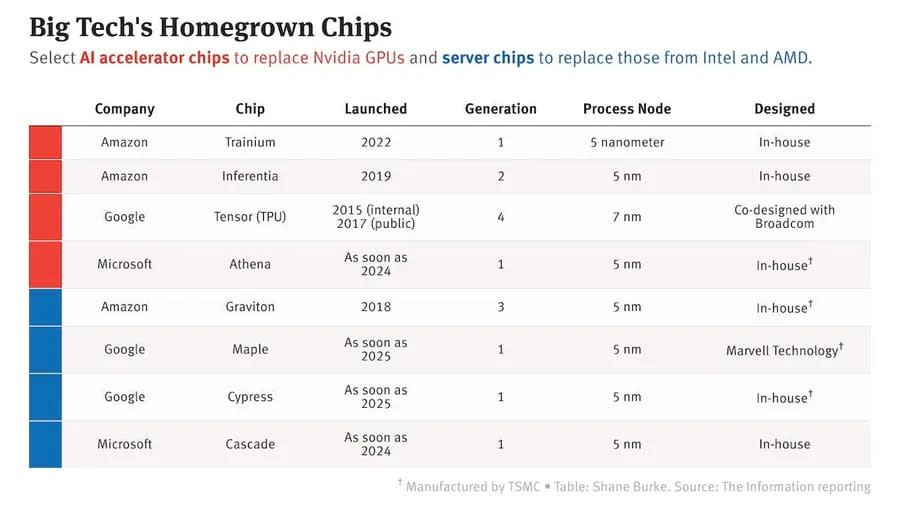

自研晶片是亞馬遜早從十年前就投入的技術,多年來也推出了多代的伺服器晶片、AI專用晶片等不同產品線,然而生成式AI的崛起,為雲端大廠和客戶同時帶來「高成本」、「高算力」的營運壓力,讓研發出強大的晶片處理器、脫離對NVIDIA單一廠商的依賴,達到前所未有的重要性。

生成式AI大戰中,亞馬遜怎麼站上風頭?

對亞馬遜來說,長久投入自研晶片成為AI時代的最大助力。AWS執行長亞當.謝利普斯基(Adam Selipsky)自信滿滿地喊出:「我認為我們比地球上任何其他人,都更有能力提供客戶發展人工智慧所需要、且充足的算力。」知名研調機構Gartner副總裁奇拉格.德卡特(Chirag Dekate)也在8月受訪時直言,在微軟、Google等其他市場競爭者威脅下,晶片將是亞馬遜最重要的突破口,可以賦予生成式AI方面的優勢,並加大差異性,「你猜怎麼著?微軟並沒有Trainium或Inferentia。」

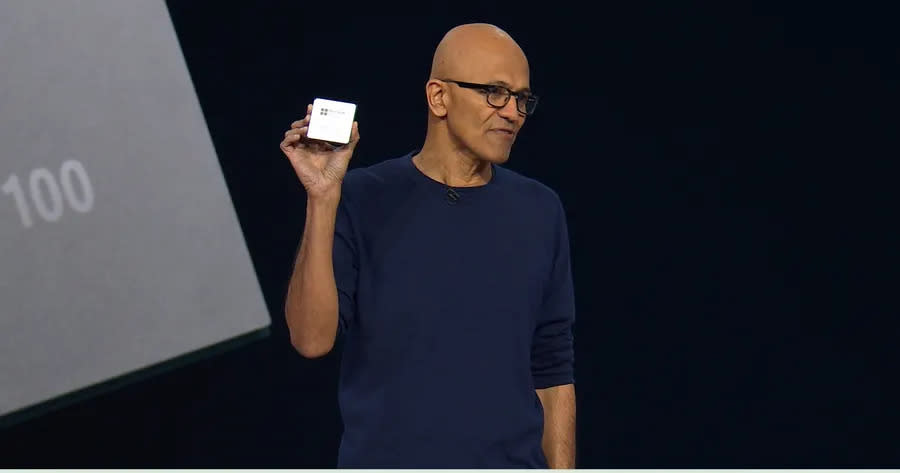

然而微軟也沒打算在這塊領域讓AWS「安心」,在今年的Ignite雲端大會中端出自研晶片Maia 100,對標AWS的訓練和推論晶片,同場也發表了伺服器中央處理器Cobalt 100,瞄準的是AWS已經推出第四代的Graviton處理器,而另一位對手Google,除了手握自研TPU晶片外,還預期會在2025年前推出全新晶片產品。

面對對手的追擊,亞馬遜打算靠自研晶片省成本、省能源等優勢「吸住」百萬雲端客戶,同時更和AI領域中「敵人兼夥伴」的輝達(NVIDIA)聯手,把高階GPU資源納入麾下,力求保障未來生成式AI之路走得順遂。

對內:深耕10年推4大自研晶片處理器,嗆「對手做不到」

亞當在亞馬遜最重要的開發者大會re:Invent開場10分鐘內,先後強調了AWS多年自研晶片的歷史和技術實力,同時高呼「這不是其他雲端公司可以做到的事情」。

目前在亞馬遜、微軟和谷歌這三家雲端巨頭之中,亞馬遜確實是唯一一家能在伺服器中提供四種類型客製化晶片——「標準計算晶片」、「訓練專用晶片」、「推理專用晶片」,以及「伺服器晶片」的雲端提供商。

不只類型最多,開始投資自研晶片技術的時間也最早,AWS的自研晶片史最早可以追溯到2013年,至今旗下已有四大晶片產品線。

1.Nitro:2013年推出,是一款用來「加速」功能輸入/輸出的晶片,目前已經推出第五代,也是最暢銷的一款產品,如今已經有超過2千萬台伺服器都在使用這款晶片。

2.Graviton:2018年推出,一款ARM架構設計的處理器,用來提高「雲端伺服器」的運算效率,短短四年已經推出第五代產品,AWS在全球也構建超過200萬個Graviton處理器,並擁有超過50,000名客戶。

3.Inferentia:2019年推出,一款針對模型「推論」功能的晶片,加快模型進行預測、推理工作,目前推出第二代,輸送量提升高達4倍,延遲降低高達10倍,採用台積電5奈米製程。

4.Trainium:2022年推出,針對模型「訓練」功能的晶片,能夠加快模型訓練的速度,目前推出第二代,大型語言模型訓練速度比上一代快4倍,能源效率也提高2倍,採用台積電5奈米製程。

在這段期間,亞馬遜也開了一次「外掛」,於2015年大手筆以3.7億美元(約新台幣114億元)的價格,收購以色列晶片公司Annapurna Labs,以晶片架構設計的專業能力,入主AWS核心的晶片開發部門,負責設計Nitro、Graviton、Inferentia和Trainium這四大主力產品。

不過目前生成式AI領域的佼佼者微軟和Google,也都在加緊投入自研晶片。微軟於2023首次推出晶片Maia 100和雲端伺服器處理器Colbert 100應戰,Google則是靠一款TPU加強終端裝置的AI應用。兩家目前都有傳出新晶片研發中的計畫,預計最快在2025年登場。

面對競爭對手的追趕,AWS資料庫、分析和機器學習副總裁史瓦米(Swami Sivasubramanian) 認為,投入時間早、技術資源充足是亞馬遜最大的本錢,「我們並非在ChatGPT 這件事發生後,才匆忙制定了一個計劃,因為你不可能在那麼快的時間內設計出晶片,更不用說在大約2到3個月之內建立起一個技術平台。」強調自家的晶片已經迭代進化,並且不只提供算力,前端協助企業客製化訓練的平台Bedrock也已經就緒,雙邊相輔相成讓企業快速投入AI領域。

三家公司目前在基礎建設的投資力道都非常強勁,美國銀行(BofA)分析師已調高亞馬遜、Google與微軟2023年的雲端支出總額成長率到14%,並預估今年將成長22%至1,160億美元。這三家公司在去年的雲端支出約為840億美元。

對外:和輝達「盡釋前嫌」,合作推超級電腦搶最大算力

2023年亞馬遜在生成式AI領域另一大突破性進展,在於和晶片龍頭NVIDIA的緊密合作上。

市場曾盛傳有「瑜亮情節」瀰漫在亞馬遜和輝達(NVIDIA)兩家巨頭之間,尤其身為數一數二GPU大客戶的亞馬遜走向自研晶片策略,而輝達又透過投資新創、拉夥伴合作等方式,把手伸向雲端市場,雙方不斷發生利益衝突,在對方的領域積極「卡位」。

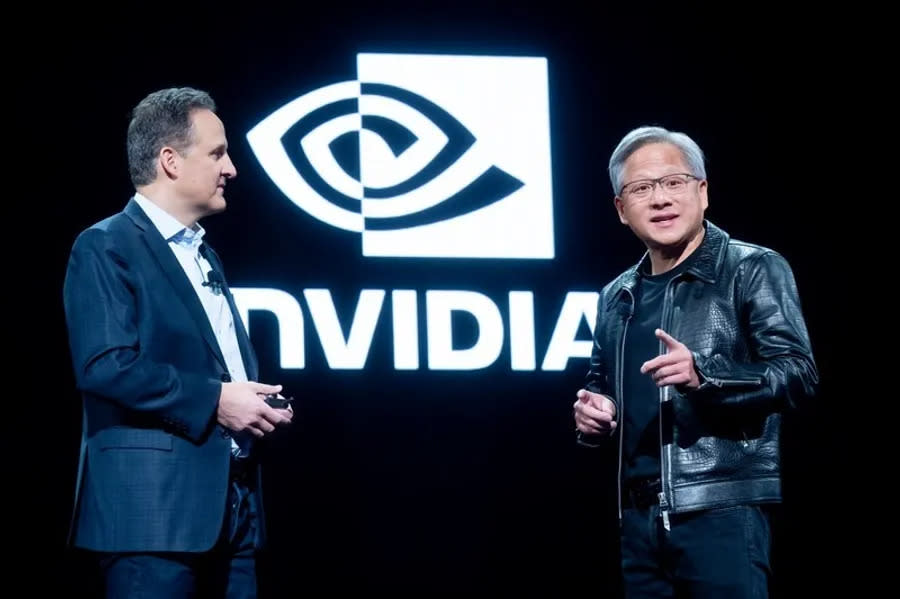

然而跑遍各大公司站台的輝達執行長黃仁勳,在2023年也史上第一次站上AWS re:Invent的舞台,「AWS是第一家強調GPU加速的雲端公司。」黃仁勳在分享時強調,亞馬遜對於硬體和基礎建設的技術實力和投資力度,並和亞當共同發表一連串重磅合作計畫。

內容包括AWS的資料中心將會是全球首家採用2024最新一代H200高階GPU,並且將引入NVIDIA DGX Cloud伺服器,雙方更宣告正在合作設計一款世界上最快的AI超級電腦,配備1.6萬顆GH200超級晶片,相當於65台超級電腦集結的算力,將用來推動下一波生成式AI創新,讓亞馬遜的基礎建設再度進化,不合傳聞也不攻自破。

活動結束後,《華爾街日報》為這場合作下了斗大的標題「 亞馬遜和輝達需要彼此 」,文中指出輝達在晶片的領先技術難以被雲端廠商的自研晶片部門複製,因此亞馬遜仍然需要輝達最先進的產品來支援雲端運算和AI發展。

延伸閱讀:一場發表會,透視亞馬遜生成式AI佈局!擁AWS「王牌」,能後發先至嗎?

另一方面,輝達也無法疏遠亞馬遜這位「全球最大買家」,從2022往前推算四年,亞馬遜的年度資本支出總額是微軟的兩倍以上,2022年的資料中心支出總額也比微軟多出39%。除此之外,輝達受到美國管制中國輸出晶片的措施影響銷售,因此和亞馬遜這類美國大客戶建立好關係,將是未來的重要發展策略。

亞馬遜希望靠著自研晶片和輝達加持的伺服器等紮實的基礎建設,降低客戶的AI成本、提升能源效率,藉此持續獲得客戶的青睞,因為 AWS的「雲端霸主」地位,正是亞馬遜重要的底氣 。

德卡特指出,數百萬的AWS客戶預計會持續留在亞馬遜麾下,因為客戶已經長期在AWS中運行應用程式、儲存數據,IT人員也非常熟悉使用方法,這都是加速AI發展的重要因素,「亞馬遜不需要贏得頭條新聞,他們已經有非常強大的雲端客戶基礎,需要做的就是吸引現有客戶使用生成式AI,創造更大的價值。」

延伸閱讀:亞馬遜的「Q」取名來自007?跟微軟「賈維斯」打對台?AI戰略大解密

參考資料:The Information、Wall Street Journal、CNBC

責任編輯:林美欣

更多報導

美國直擊|亞馬遜推企業級聊天機器人Q,劍指微軟Copilot!更新千個Java App只要2天

專屬台灣!優必達攜手台大打造「Taiwan LLM」,為何我們需要本土化的AI?

Yahoo奇摩新聞

Yahoo奇摩新聞