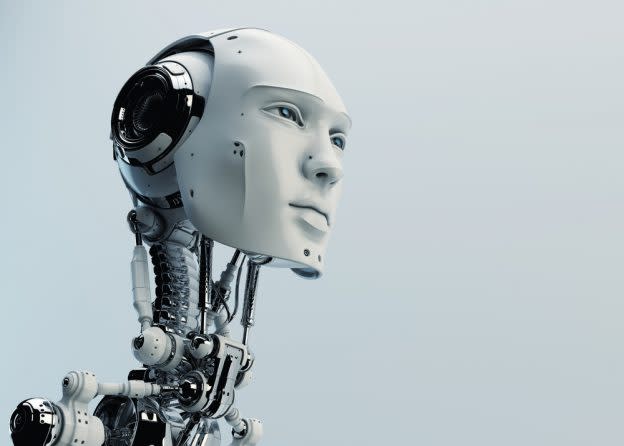

DeepMind 想透過認知心理學,來弄清楚人工智慧的思考模式

隨著技術發展,人工智慧(AI)已應用在做一些簡單決定,應用領域與複雜度也在持續拓展中,未來 AI 可能會在自駕車上做出攸關生命的抉擇,但 AI 工程師面臨一個問題:他們通常不知道自己的創作在想什麼。

機器的神經網路

華爾街日報報導,AI 難以被定義,之所以會有這樣的現象,和神經網路的使用有關。

當研究人員開始透過「學習」訓練機器,將經驗轉化為模擬神經網路的系統,產生出的結果不是代碼,而是由不可讀、數百萬甚至數十億的人造神經元,給出 AI 工程師賦予任務的答案。

多數研究人員都同意,認識 AI 是一項迫切的挑戰。如果我們不知道人造思維如何運作,又該如何確定它抱持偏見或預測錯誤的結果?

我們不會知道 AI 是否有「種族歧視」,或是無法預期的思維讓自駕車可能發生事故,或許有機會能辨別 AI 對事物是否抱持著偏見,那可能會是 AI 做出無數個決定之後的事了。

去理解 AI 什麼時候可能會失敗或出現意外行為,是非常重要的,畢竟我們都不希望關鍵時刻出現任何意外,或是聽到「很抱歉,但我恐怕不能這麼做」。

AI 不帶偏見?

Pinterest 的軟體工程師 Tracy Chou,在公司內專門負責機器學習項目,他認為 AI 發展中很大的問題在於,多數人都把 AI 或機器學習想得過於「中立」。

「多數人都不了解的是,是人類設計了這些 AI 模型,也是人類選擇要用什麼數據來訓練機器。」

華爾街日報試著用一個最簡單的例子來解釋:Google 翻譯。當你在 Google 翻譯上輸入「醫生」,要求翻譯成葡萄牙語時,總是會得到陽性名詞 médico,而非陰性名詞的 médica;輸入「護士」時,則會得到陰性的 enfermeira,而非陽性的 enfermeiro。

聽起來有些陰謀論,但這其實只是用來訓練翻譯系統的文學體系,舊有的偏見所導致的自然結果。類似的事情其實經常發生,在研究人員並未注意到的情況下,AI 很有可能在無意中成為偏見的代理人。

和人類不同的是,我們不能直接詢問機器「為什麼這麼做?」儘管 AI 在限定的環境條件下能表現十分出色,但談到內省(introspection)的能力,AI 的程度可能與蟑螂差不多。

如何解讀 AI 的思考

應該如何解讀人工智慧?這是一個困難的問題,就連美國國防高級研究計畫署(DARPA)都在提供資金給相關研究人員,希望能夠解決這個問題。

在機器學習中,工程師先是編寫了類似原始大腦的神經網路,再透過給予大量數據來進行訓練,機器則從中學習辨別與理解,就像大腦運作的方式一樣,也因為如此,AI「思考」的方式人無法理解。

這個困境工程師稱之為「可解釋性」問題,而神經網路則稱為「黑盒子」──你可以刺激並觀察,但無法理解內在。

身為現今最知名 AI「AlphaGo」的開發者,Alphabet 的子公司 DeepMind 研究團隊也希望解決這個問題,因此決定用一個全新方式來了解 AI:就像對待人類的孩子。

這並不是一個比喻,DeepMind 的研究科學家 David Barrett 表示,團隊正在使用和心理學家用在孩子身上的認知心理學技術及測試,來試圖了解 AI 的想法。

Barrett 認為,認知科學對人腦的研究已有數十年,如果應用到機器的過程順利,將能理解 AI 的思考模式,並為它的決定負責。

在研究中,DeepMind 至少已理解了 AI 的一種學習模式:一次性學習思考。這個設計原先是用來讓 AI 看過一次項目後,就學習單字的意思,DeepMind 意外發現,AI 解決這項問題的方式和人類相同,是透過形狀來辨別物體。

研究人員發現,即使沒有著指導,也存在著許多方法來識別隨機對象,像是顏色、質感及行為模式,AI 卻是選擇像人類一樣用形狀來識別物體,這樣的行為模式是以前未曾察覺的。

機器人心理學

類似這樣對 AI 思考的理解只是開始,就像人類心理學一樣,機器人心理學未來也可能發展出一種「治療」行為──也就是去改變 AI 的心態。

工程師在創造 AI 時,經常會選擇創造多種版本,以便於從中找出最好的來使用,Barrett 認為,透過認知心理學的應用,工程師可能會更容易創造出「想法」符合人類需求的 AI。

又或者,我們也可能從中發現,AI 的思考模式與人類有所不同,人們或許能從中學習到一些新的東西,像是該如何解決一些問題。

在用人工智慧取代人類決策者時,我們總是希望機器做得更好,犯更少錯誤並承擔責任。當 AI 的產出能被衡量,人們或許就能夠追蹤它們做決定背後的過程。

在現今法庭中,我們總是由人來解決商業問題上的爭執,如果改由機器取代人力,我們或許就能夠觀察到「決策者」在過程中的心態轉變,與所有可能出現的偏見。

Yahoo奇摩新聞

Yahoo奇摩新聞