RTX 4090顯卡亮相,售價5萬元起!Nvidia GTC大會還端出哪些好料?

Nvidia GTC大會正式登場,執行長黃仁勳在演講中端出了眾多新的顯卡系列、AI晶片、自駕晶片、AI訓練服務等GPU領域的各種軟硬體更新,不過最受觀眾期待的,莫過於傳言已久的RTX 40系列顯卡。

RTX 4080、4090登場,性能倍增玩遊戲更順暢

「今天我們宣佈推出Ada Lovelace,第三代RTX。」Keynote演講開場5分鐘,黃仁勳便切入主題,向觀眾們揭曉以數學家為名的新一代顯卡架構,以及使用該架構的RTX 4080、RTX 4090顯卡。

根據Nvidia的介紹,Ada Lovelace使用台積電4奈米製程技術打造,擁有760億個電晶體、18,000個CUDA核心,較目前30系列顯卡使用的Ampere架構多出70%,在多工處理、光線追蹤等各種面向上都有長足進步,並能更有效率地運用GPU資源。

同時Ada Lovelace搭載的DLSS 3,採用全新AI技術能夠產生高畫質的全新影格(frame),不單單只是像素(pixel),並且不必處理繪圖流程,進而將遊戲性能大幅提昇。

而使用Ada Lovelace架構的高階顯卡RTX 4090,具備高達24GB的GDDR6X記憶體,能夠在耗電量相同的情況下,遊玩遊戲時有有著上一代RTX 3090 Ti 2至4倍的效能,而3D彩現、影片編輯等創作應用上,也能將工作流程執行速度提昇至兩倍,進而節省創造者寶貴的時間。

RTX 4080則有兩種款式,一款具有12GB GDDR6X記憶體、另一款則有16GB GDDR6X記憶體,Nvidia也聲稱其有著RTX 3080Ti 2至4倍的性能。

按照目前披露的資訊RTX 4090預計10月12日上市,售價1,599美元(約新台幣5萬元)起,而兩款RTX 3080則預計11月登場,12GB預計售價899美元(約新台幣2.8萬元),16GB預計售價1,199美元(約新台幣3.7萬元)。

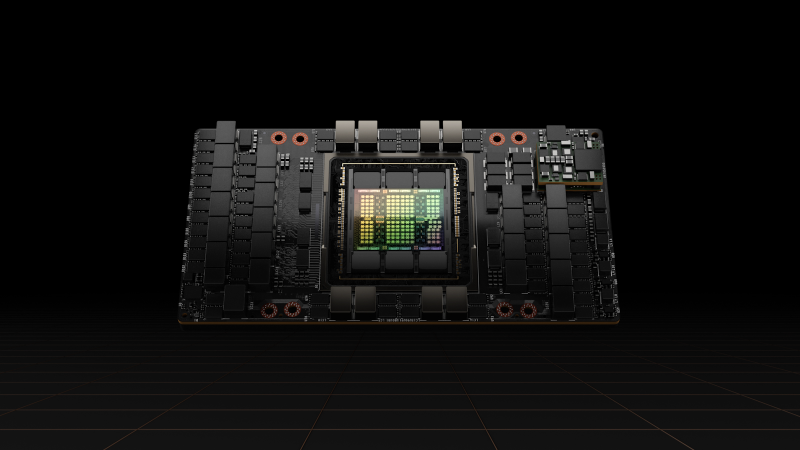

H100 AI晶片進入量產,10月正式發貨

除了眾所矚目的顯卡,在快速成長的資料中心領域,Nvidia也宣佈H100 GPU,已經進入量產階段,即將於10月正式發貨。這是Nvidia至今最強大的一款AI晶片,搭載800億個電晶體以及Transformer引擎,能夠加快機器學習的效率。

按照先前披露的測試資訊,H100較前一代的A100性能達到4.5倍,倘若維持與A100同樣的性能,則有著3.5倍的能源效率,足以將擁有成本(cost of ownership)降低為3分之1。

Nvidia預計,今年底前就會有不同公司,多達50種以上採用H100的伺服器型號進入市場,而他們也計畫將H100與Grace CPU結合推出的Grace Hopper,預計會在2023上半年亮相。

值得注意的是,H100先前曾遭受美國政府禁止先進AI晶片銷往中國、俄羅斯限制的影響,雖然得到了一年的寬限期,如何降低禁令衝擊仍是未來必須面對的難題。

針對車用領域發表Drive Thor,集結Nvidia各方面技術

電腦定義正不斷更新,現在人手一台的智慧型手機已然是電腦,而未來汽車也是會有著四個輪子的電腦。Nvidia在這次發表會上,同樣針對車用需求端出了一款名為Drive Thor的系統單晶片(SoC)。

現在汽車中的主動安全系統、儀表板、娛樂系統、後照鏡等各式設備,都是分別由不同的電腦負責控制,不過在黃仁勳的展望中,未來全都會在一個中央處理器上運行。

也因此,Nvidia決定推出Drive Thor,結合Hopper的Transformer引擎、Ada Lovelace的GPU、Grace的CPU,可說是Nvidia技術的集大成,足以提供2,000 teraflops性能,提供整輛車所需的運算能力。

Nvidia聲稱,Drive Thor取代了同系列的Drive Atlan,並讓Drive Orin未來能無縫接軌升級。黃仁勳認為,未來不只是汽車,機器人、醫療機械、工業自動化、邊緣AI系統都能運用這項技術。

讓打造AI模型更簡單,Nvidia推出協助AI訓練新服務

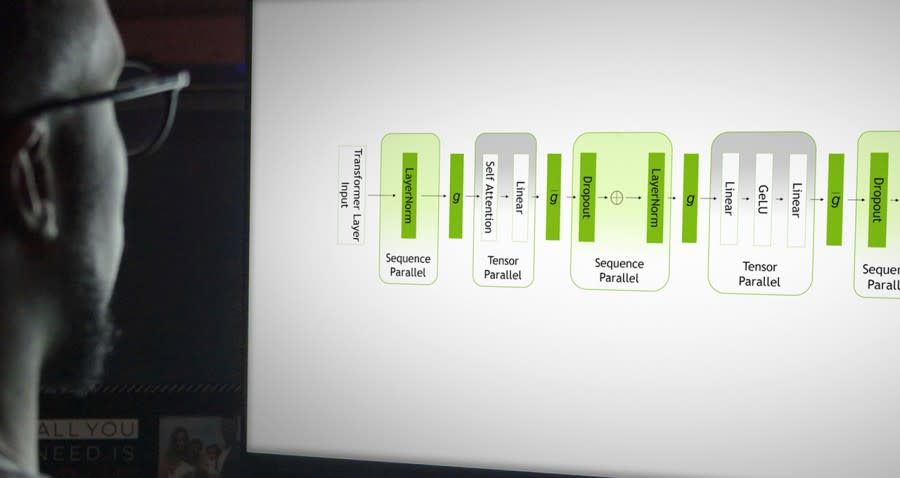

不光是硬體上的革新,Nvidia也在這場GTC大會上,發表了協助AI訓練的新服務。

黃仁勳表示,大型語言模型(LLM)是現在AI領域中最重要的模型,能夠在無須數據標記的情況下理解語言含意,進而發揮各種功能。然而大型語言模型成本不菲,Google最新語言模型PaLM訓練成本外界估計高達920萬到2,310萬美元之間,雖然浮動很大仍能看出訓練大型語言模型花費有多高。

為了讓研究人員更容易使用這樣技術,便端出了NeMo LLM、BioNeMo LLM兩項新服務。NeMo LLM是一個聊天機器人的開源工具包,讓開發人員可以不必從開始打造LLM,幾個小時內就能做出有著上千億參數的AI模型。

而BioNeMo LLM則專門針對生物科學領域的需求,該模型能夠理解各種化學物質、蛋白質、DNA、RNA等各種生物科學領域的概念,目前已經與基因生技的頂尖研究機構The Broad Institute合作。

Nvidia推雲端板Omniverse,串連全球力量打造元宇宙

另外,在前幾次GTC大會擔綱主角的影像擬真3D設計協作平台Omniverse也沒有缺席。黃仁勳就披露,Omniverse已經獲得大量客戶採用,好比說通用汽車就利用Omniverse設計工作室的「數位分身」,讓設計師、工程師、行銷人員可以在虛擬空間中協作。

美國零售商勞氏(Lowe's)一樣借助Omniverse的力量,來設計、打造門市的數位分身;美國第二大有線電視、寬頻業者Charter則利用Omniverse建立4G及5G網路的數位分身。

黃仁勳這次對外介紹了雲端版本的Nvidia Omniverse Cloud服務,也是Nvidia第一款SaaS產品,目前已獲得廣告集團WPP、西門子、超跑車廠RIMAC率先使用。

RIMAC聲稱,Omniverse Cloud能夠節省他們花費在3D模型設計的時間,從而將更多專注力放在車身本身的設計上,提昇了效率與靈活應變的能力。

「元宇宙──意即3D的網際網路,連接了使用通用場景描述的虛擬3D世界。」黃仁勳認為,「藉由雲端上的Omniverse,我們可以連結世界各地的團隊,一同設計、打造、運行虛擬世界和數位分身。」

資料來源:Nvidia、The Verge、Engadget

責任編輯:錢玉紘

更多報導

EVGA掰了Nvidia!GeForce顯卡銷售佔了營收80%,為何要果斷分手?

美國禁止NVIDIA高階AI晶片銷往中國!估營收失血4億美元

Yahoo奇摩新聞

Yahoo奇摩新聞