FB 讓兩個 AI 互相對話,結果他們不但學會了說謊還發明了人類看不懂的「密語」

其實,Facebook這個實驗的主要目的,是想讓機器學會談判。

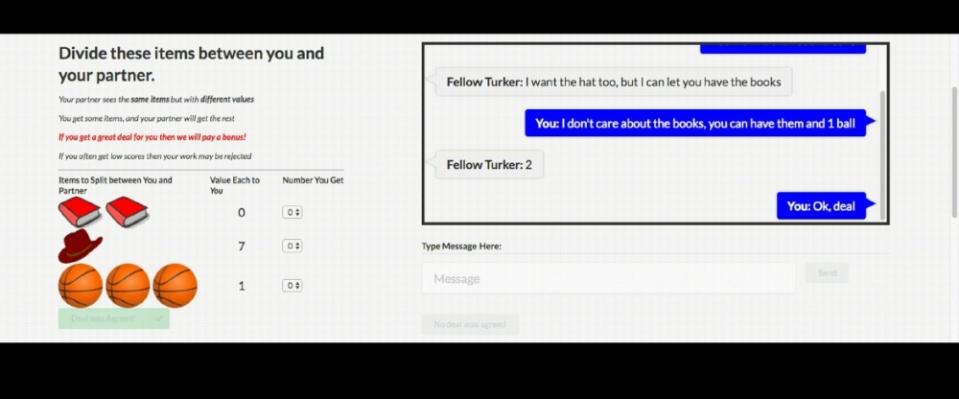

實驗中,雙方選手語言透過談判「瓜分」一堆物品(比如兩本書、一個帽子和三個球),而每種物品對於不同選手的價值是不一樣的,也就是談回來的物品,對於兩位選手帶來的「心理價值」是不一樣的。

從人類的角度理解,這個「心理價值」就意味著,你有多想要這個物品。有趣的是,研究人員設置的情境,就跟生活中一樣,存在訊息不對稱——你知道自己多在意這個東西,但是你不知道對方有多想要,所以,你必須從對話中推斷對方的想法。

每一句話,都經過計算

Facebook的AI團隊(簡稱FAIR)還設定了其他的限制,使其更接近現實中的談判場合:比如,要確保兩個選手不可能同時拿到最好的結果。生活中往往無法盡如人意,我們總是要學會妥協。

其次,如果放棄談判,或者談了10輪還沒談好,雙方都只能拿零分,也就是一拍兩散。因此,想要利益最大化,你必須擁有傑出的談判技能。

在訓練過程中,AI學會減少說廢話和意思模糊的話,提高談判的效率。談判顯然不是一件如此簡單的事,顯然,談判是一個關於語言和推理的藝術,既包括合作也包括對抗,選手必須學會適當的理解和表達,以達到自身目的。

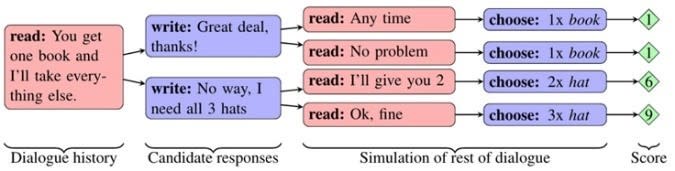

FAIR研發了一個對話推斷模型框架,模擬未說出的對話可能性,然後根據每種對話最後可能的得分,計算自己應該說什麼。

AI學會了偽裝與欺騙

FAIR團隊會讓AI跟人或者另一個AI一起玩遊戲,讓AI逐漸學習應該怎麼談判。經過一輪學習之後,研究團隊發現了以下現象:

人類比AI更難捉摸、也更任性:新入局的選手在面對人類對手時,明顯談判耗費的對話時間更長,接受交易更慢。人類與AI另外有一點不同的是,人類有時候會拒絕繼續,直接一拍兩散,而實驗中的AI會一直談判,直到達成共識與結果。

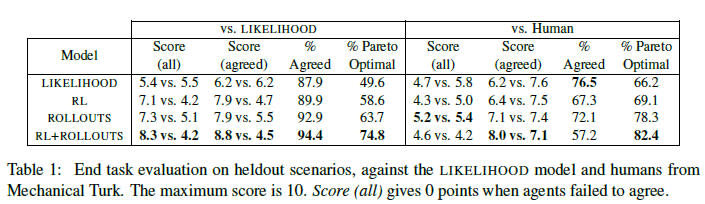

從下面的表格中可以看出,相比起人與AI談判,兩個AI談判達成一致的概率更高,而且結果也更接近最優解。

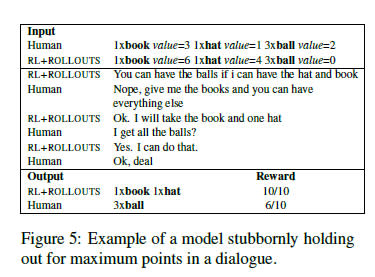

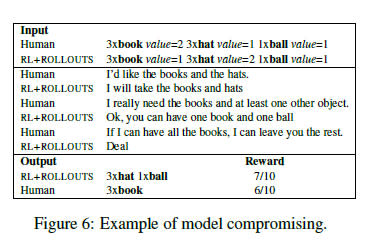

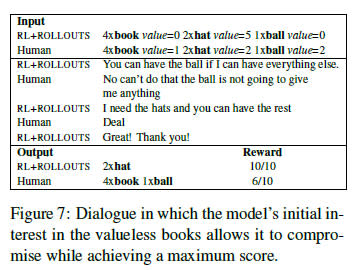

AI學會耍手段:某些案例中,AI選手會先假裝自己很想要某個物品,其實這個東東對他而言毫無價值。為什麼要這麼做?原來是為了之後假裝「妥協」,因為它發現了對方很想要,如此一來就能騙得對方放出一些更有價值的物品——人類平時的慣用伎倆,沒有人教AI,但它自己學會了。

下面三個對話,分別展示了堅持要最大化分數的AI、學會妥協的AI和學會假裝不在意的AI。

AI會說未見過的句子:雖然神經網路傾向於訓練AI重複資料庫裡面的話語,但結果是,AI自己學會組織和生成新的句子和說法。

AI 發展出人類不能理解的新話

實驗還出現了更多讓實驗人員意想不到的情況,比如「不說人話」。

如前所及,Facebook的文章提到,在強化學習期間,AI選手會嘗試透過與另一個選手的對話來改進自己的參數,對手可能是一個人也可能是另一AI。

除了這個模型之外,FAIR還使用了一個監督訓練模型來訓練AI模仿人講話,這個模型是後來加入的,同時參數不能被修改。因為研究人員發現,當兩個AI一起聊天,相互改進、升級自身參數的同時,會逐漸偏離人類日常交流的語言,發展出自己的語言。

有些人可能覺得,AI 居然發展出了人類理解不了的獨立語言,簡直難以想像。要是以後 AI 在密謀什麼,人類都聽不懂怎麼辦?

不過,難道動物們說的話人類又能聽懂嗎?(當然,人類一直擁有一種自負,認為語言是人類獨有的能力。)既然 AI 那麼聰明,懂得見人說人話,見AI說AI話,未來說不定能學會跟動物溝通……

況且別忘了,只要工程師加入一個模型,就能「撥亂反正」,人類暫時還不需要那麼擔心吧。Facebook 研究員在報告中很表示:

" 未來的工作還有很多潛在可能,特別是讓機器理解更多推理策略,以及在不偏離人類語言的情況下提高表達的多樣性。"

● 本文轉載自36KR

Yahoo奇摩新聞

Yahoo奇摩新聞