NVIDIA 的 H100 資料中心 GPU 比前代快上六倍

NVIDIA 是在去年差不多這時候,發表了其首款資料中心處理器「Grace」,不過當時除了知道它會以 ARM 為核心,並使用 NVIDIA 自家的 NVLink 技術之外,並沒有太多的細節。今天在 2022 年的 GTC 上,CEO 黃仁勳終於公開了更多 Grace 的內容,包括以其為基礎的 Grace CPU 超級晶片(Superchip)。

Grace CPU 以 ARM 的 v9 架構打造,而 Grace 超級晶片更是將 Grace CPU 與 Hopper GPU(後面會詳述)或是兩顆 Grace CPU 透過 NVLink 連接在一起,和蘋果近期發表的 M1 Ultra 頗有異曲同工之妙。兩顆 Grace CPU 整合後的處理器有著 144 顆 ARM 核心,但能耗卻控制在了相對合理的 500W。

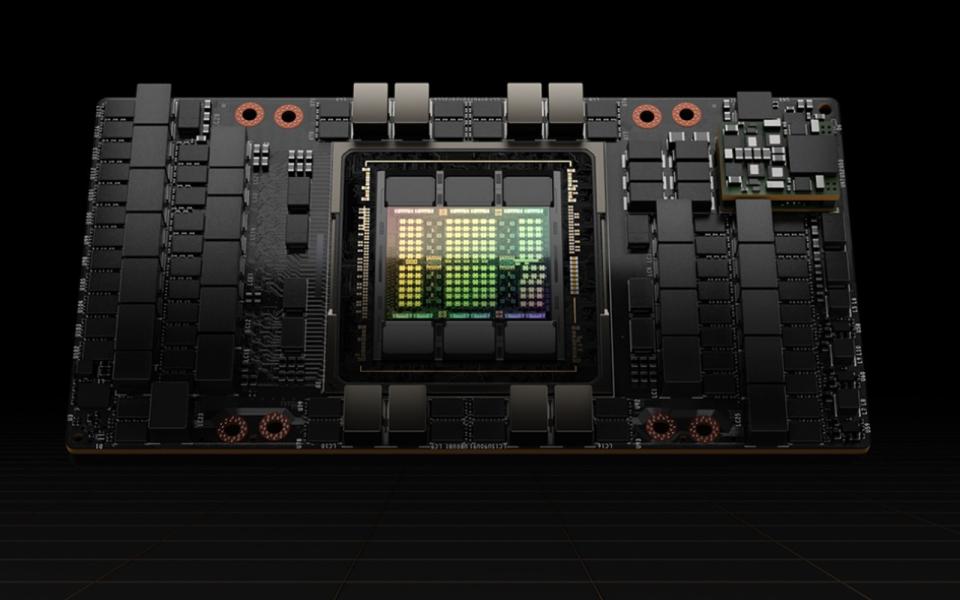

與 Grace 同時登場的,是名為 Hopper 的新世代 GPU 架構。Grace 和 Hopper 兩個代號其實來源相同,都是美國知名的電腦科學家與程式設計師 Grace Hopper,由此可以看出 Grace CPU 與 Hopper GPU 架構的緊密關聯。Hopper 將接替 Ampere 成為新一代的高性能架構,但初期將僅供資料中心和 AI 訓練等高強度的應用使用。其核心的 H100 GPU 將以台積電的 4nm 製程打造,並擁有高達 800 億個電晶體。Hopper 架構並將特別專精於一種名為 Transformer Engine 的特殊 Tensor core,來迎合機器學習市場在這方面的高度需求。相對於 Ampere 的 A100,在一般使用下 H100 可以快上 6 倍之多,而如果是 Transfomer 運算的話,則可是能達到 16x 至 30x 的速度提升呢。

NVIDIA 預計在 2023 年上半起將 Grace Superchip 出貨給美國能源署等單位,屆時可以單購 CPU 系統,或是與最多 8 個 Hopper 搭配為一個伺服器整體。至於 H100 的話,則會出現在 NVIDIA 自家的 DGX 和 DGX SuperPod 伺服器中,也會透過 OEM 伙伴銷售 PCIe 卡等產品。不過無論是哪種形態,它們應該都是高度客製化的系統,決非一般消費者會用得到的,因此也就沒有標價了。

Yahoo奇摩新聞

Yahoo奇摩新聞